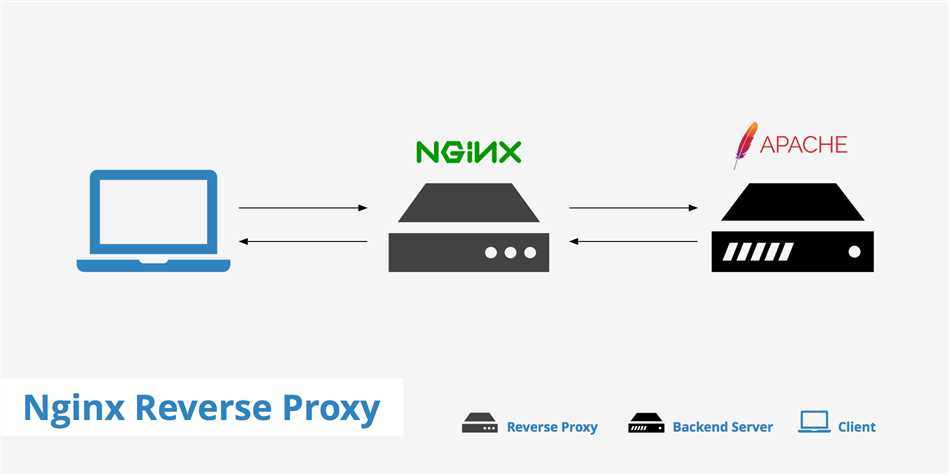

Для обеспечения безопасности и повышения производительности веб-серверов, таких как Nginx, используется функция Proxy pass. Эта функция позволяет перенаправлять запросы от клиента к одному серверу на другой сервер, не раскрывая источник и не передавая пользовательские данные. Таким образом, можно управлять трафиком и балансировать его между несколькими серверами.

При использовании Proxy pass, Nginx принимает запрос от клиента и перенаправляет его к указанному серверу. Это позволяет анонимизировать клиентский IP-адрес и защитить серверы от прямого доступа, а также распределить нагрузку между несколькими серверами, увеличивая производительность и отказоустойчивость.

Proxy pass является важным инструментом веб-разработчиков и администраторов серверов, который обеспечивает безопасность и эффективное использование ресурсов.

Краткое описание

Использование proxy pass очень полезно в ситуациях, когда требуется распределение нагрузки между несколькими серверами, балансировка трафика или обеспечение доступа к приватным ресурсам. Преимущества такого подхода заключаются в повышении производительности, улучшении отказоустойчивости и упрощении масштабирования.

Для настройки proxy pass нужно добавить соответствующую директиву в конфигурационный файл Nginx. В этой директиве необходимо указать адрес сервера, на который должны быть перенаправлены запросы. Также можно указать дополнительные параметры, например, порт или путь к ресурсу на сервере.

Пример использования proxy pass в конфигурации Nginx:

location / {

proxy_pass http://backend-server;

}

В этом примере, все запросы, начинающиеся с корневого пути («/»), будут перенаправляться на сервер с именем «backend-server».

Кроме того, в настройках proxy pass можно сделать балансировку нагрузки между несколькими серверами, указав их адреса в виде списка:

upstream backend {

server backend-server1;

server backend-server2;

}

В этом случае, Nginx будет распределять трафик между серверами backend-server1 и backend-server2.

В результате использования proxy pass в Nginx можно значительно улучшить производительность и надежность веб-приложений, а также обеспечить масштабируемость и отказоустойчивость системы.

Преимущества использования Proxy pass в Nginx

- Балансировка нагрузки: Одним из ключевых преимуществ Proxy pass является возможность распределять нагрузку между несколькими серверами. Это особенно полезно при работе с высоконагруженными приложениями, где один сервер может быть недостаточным для обработки всех запросов. При использовании Proxy pass, Nginx может автоматически распределять запросы между серверами, обеспечивая более стабильную и отказоустойчивую работу системы.

- Кэширование: Еще одно преимущество Proxy pass в Nginx — возможность кэшировать данные. Кэширование позволяет снизить нагрузку на сервер и сократить время отклика. Nginx может сохранять ответы от backend сервера и использовать их для обработки последующих запросов. Это особенно полезно для часто запрашиваемых статических ресурсов, таких как изображения, CSS и JavaScript файлы.

- Защита от DDoS-атак: Proxy pass в Nginx позволяет защитить сервер от DDoS-атак. Он может отклонять запросы, которые превышают установленный лимит, и блокировать IP-адреса атакующих. Это помогает обеспечить стабильную работу сервера и защитить его от перегрузки и отказа в обслуживании.

- Обеспечение безопасности: Еще одно важное преимущество Proxy pass в Nginx — это возможность обеспечить безопасность сервера и приложения. Nginx может выполнять фильтрацию и блокировку запросов, содержащих вредоносный код или попытки взлома. Он также может работать с SSL-сертификатами, обеспечивая защищенное соединение с клиентами.

- Удобство настройки: Proxy pass в Nginx обладает гибкой системой настройки. Он позволяет легко добавлять, изменять и удалять прокси-серверы и правила маршрутизации в конфигурационных файлах. Это упрощает работу с Nginx и позволяет быстро адаптировать его под изменяющиеся требования вашего проекта.

В целом, использование Proxy pass в Nginx позволяет эффективно организовать работу сервера, обеспечить высокую производительность и безопасность, а также упростить настройку и управление конфигурацией. Он является незаменимым инструментом для оптимизации работы веб-серверов и приложений. Попробуйте использовать Proxy pass в Nginx и убедитесь в его многочисленных преимуществах самостоятельно!

Конфигурация Proxy pass в nginx

Proxy pass в nginx представляет собой настройку, которая позволяет перенаправлять запросы клиентов к одному серверу на другой сервер. Это часто используется для балансировки нагрузки, когда несколько серверов хранят копии одного и того же контента и nginx выбирает наиболее подходящий сервер для обработки запроса.

Для настройки Proxy pass в nginx, вам необходимо добавить директиву «proxy_pass» в соответствующий блок конфигурации сервера. Например:

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend-server;

}

}В этом примере, все запросы, поступающие на порт 80 и адресу example.com, будут перенаправляться на сервер, указанный в директиве «proxy_pass» с префиксом «http://». В данном случае, «backend-server» может быть доменным именем или IP-адресом сервера, на который нужно перенаправить запросы.

Вы также можете настроить прямое проксирование (forward proxy) или обратное проксирование (reverse proxy). Прямое проксирование позволяет клиентам использовать сервер nginx для доступа к внешним ресурсам через прокси-сервер, а обратное проксирование позволяет серверу nginx получать запросы от клиентов и перенаправлять их к одному или нескольким серверам.

Помимо директивы «proxy_pass», вы можете использовать такие дополнительные директивы, как «proxy_set_header» для настройки HTTP-заголовков, «proxy_connect_timeout» и «proxy_read_timeout» для установки тайм-аутов соединения и чтения, а также «proxy_buffering» для включения или отключения буферизации ответов от прокси-сервера.

- Прямое проксирование: при прямом проксировании, клиенты обращаются к серверу nginx, чтобы получить доступ к внешним ресурсам через прокси-сервер.

- Обратное проксирование: при обратном проксировании, сервер nginx получает запросы от клиентов и перенаправляет их к одному или нескольким серверам. Это позволяет балансировать нагрузку и обеспечивает высокую доступность.

- Директивы proxy_set_header: позволяют настраивать HTTP-заголовки, которые будут передаваться от прокси-сервера к конечному серверу и обратно.

- Директивы proxy_connect_timeout и proxy_read_timeout: устанавливают тайм-ауты для соединений и чтения соответственно. Это полезно для управления временем ожидания ответов от серверов.

- Директива proxy_buffering: включает или отключает буферизацию ответов от прокси-сервера. Если буферизация включена, ответы будут сохраняться в буфере и передаваться клиенту после завершения запроса к серверу.

Настраивать Proxy pass в nginx может быть полезно для множества сценариев, начиная от проксирования запросов к балансировке нагрузки и обеспечению высокой доступности. Надеемся, что эта информация была полезной для вас!

Примеры использования Proxy pass nginx

Пример 1: Балансировка нагрузки

Один из самых популярных способов использования функции Proxy pass — это балансировка нагрузки. Если у вас есть несколько серверов, на которых размещено одно и то же приложение, вы можете настроить nginx в качестве балансировщика нагрузки, чтобы распределить трафик между этими серверами. Пример конфигурации:

http {

upstream backend {

server backend1.example.com;

server backend2.example.com;

}

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://backend;

}

}

}

В этом примере, все запросы, направленные на example.com, будут передаваться на серверы backend1.example.com и backend2.example.com в равных долях, обеспечивая тем самым балансировку нагрузки.

Пример 2: Защита от DDoS-атак

Proxy pass также может использоваться для защиты от DDoS-атак, когда веб-сервер перенаправляет запросы на специальный прокси-сервер, который фильтрует трафик и блокирует подозрительные запросы. Пример конфигурации:

http {

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://ddos-proxy;

}

}

server {

listen 80;

server_name ddos-proxy;

location / {

# Фильтрация и блокировка запросов

}

}

}

В этом примере, веб-сервер принимает все запросы на example.com и передает их на прокси-сервер ddos-proxy, где выполняется фильтрация и блокировка подозрительного трафика. Таким образом, веб-сервер получает только доверенные запросы, и защищает себя от DDoS-атак.

Пример 3: Кеширование статических файлов

С помощью Proxy pass можно также настроить кеширование статических файлов, чтобы ускорить загрузку контента для клиентов. Nginx может служить как прокси-сервер для запросов статических файлов, сохраняя копии этих файлов локально и обслуживая их напрямую при следующих запросах. Пример конфигурации:

http {

server {

listen 80;

server_name example.com;

location /static/ {

proxy_pass http://backend;

proxy_cache mycache;

}

}

}

В этом примере, все запросы на файлы, начинающиеся с /static/, будут передаваться на сервер backend, а nginx будет сохранять копии этих файлов в кеше mycache. При повторном запросе файл будет обслуживаться напрямую из кеша, что значительно ускорит его загрузку.

Пример 4: Реверс-прокси для скрытия внутренних серверов

Proxy pass также может использоваться в качестве реверс-прокси для скрытия внутренних серверов от клиентов. В этом случае, nginx принимает все внешние запросы и перенаправляет их на внутренний сервер, который обслуживает контент. Пример конфигурации:

http {

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://internal-server;

}

}

server {

listen 80;

server_name internal-server;

location / {

# Логика обслуживания контента

}

}

}

В этом примере, веб-сервер принимает все запросы на example.com и передает их на внутренний сервер internal-server, который обслуживает контент. Таким образом, клиенты будут видеть только внешний сервер, а внутренний сервер останется скрытым.

Вот несколько примеров использования Proxy pass nginx. Надеюсь, данная информация была полезной для вас! Если у вас есть еще вопросы, не стесняйтесь задавать их! Я всегда рад помочь!

Proxy pass nginx: что это такое и как работает

Проксирование часто используется для повышения производительности сайта и обеспечения доступа к удаленному серверу из локальной сети. Например, если на сервере Nginx установлены дополнительные модули для кэширования, сжатия или балансировки нагрузки, то запросы могут быть выполнены быстрее и более эффективно. Кроме того, проксирование может быть использовано для доступа к защищенным ресурсам внутри локальной сети, например, к базам данных или веб-приложениям.

Для работы с проксированием в Nginx используется директива proxy_pass. Она указывает адрес сервера, куда будут перенаправляться запросы. Например, proxy_pass http://localhost:8080; перенаправит запросы к локальному серверу, работающему на порту 8080.

Кроме proxy_pass, есть и другие директивы, которые можно использовать для настройки проксирования в Nginx:

proxy_set_header— устанавливает произвольные HTTP-заголовки, которые будут отправлены на удаленный сервер;proxy_redirect— позволяет изменять URL-адреса в ответе от удаленного сервера;proxy_cache— позволяет кэшировать ответы от удаленного сервера для повторного использования;proxy_ssl— позволяет использовать SSL-соединение между сервером Nginx и удаленным сервером.

Проксирование также может быть настроено для разных путей или доменных имен на одном сервере. Для этого можно использовать директивы location и server_name. Например:

location /api {

proxy_pass http://localhost:8080;

}

location /images {

proxy_pass http://localhost:8081;

}Этот конфигурационный файл Nginx proxy pass будет перенаправлять запросы, начинающиеся с /api на сервер, работающий на порту 8080, а запросы, начинающиеся с /images, на сервер, работающий на порту 8081.

Важно учитывать, что правильная настройка проксирования в Nginx требует некоторых знаний о различных параметрах и возможностях, поэтому рекомендуется обращаться к официальной документации Nginx или консультироваться с опытными системными администраторами.